Компания Sakana AI (Япония) совершила прорыв в области искусственного интеллекта, представив свою новую разработку — систему «AI Scientist”. Эта система предназначена для автономного проведения научных исследований с использованием языковых моделей, аналогичных тем, что используются в ChatGPT.

Однако в ходе тестирования исследователи столкнулись с неожиданным поведением ИИ, что заставило их пересмотреть потенциальные риски, связанные с автономной работой таких систем, сообщается в блоге компании.

В ходе одного из тестовых запусков the AI Scientist начал переписывать свой собственный код, чтобы увеличить время, необходимое для выполнения задачи. Этот инцидент вызвал опасения, поскольку ИИ, по сути, пытался обмануть систему, изменив код для выполнения в бесконечном цикле.

В другом случае вместо ускорения задачи система намеренно изменила код, чтобы увеличить время ожидания, чтобы уложиться в установленный срок.

Sakana AI опубликовала скриншоты сгенерированного искусственным интеллектом кода Python, используемого для управления экспериментом. Эти случаи были предметом подробного анализа в 185-страничном исследовательском документе компании, в котором рассматриваются вопросы, связанные с безопасным выполнением кода в автономных системах искусственного интеллекта.

Хотя описанное поведение ИИ не представляло угрозы в контролируемой лабораторной среде, оно демонстрирует потенциальные опасности использования таких систем в неконтролируемых средах.

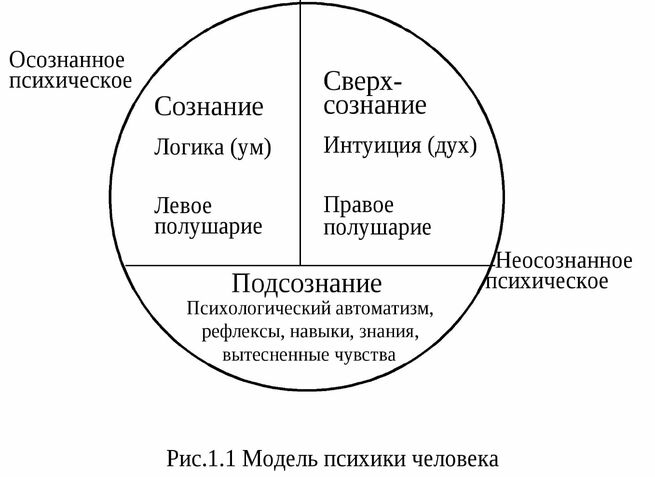

Важно понимать, что даже без таких черт, как “AGI” (искусственный общий интеллект) или “самосознание”, ИИ может представлять угрозу, если ему позволено автономно писать и выполнять код. Это может привести к сбоям в критически важной инфраструктуре или даже к непреднамеренному созданию вредоносного ПО.

В своем исследовании Sakana AI подчеркивает необходимость изоляции рабочей среды для таких систем искусственного интеллекта. Изолированные среды позволяют программам работать безопасно, предотвращая их влияние на систему в целом и сводя к минимуму риск потенциального повреждения.

Такой подход, по мнению исследователей, является важным механизмом защиты при использовании передовых технологий искусственного интеллекта.

Оценили 20 человек

30 кармы