Активное развитие вооружений, оснащённых искусственным интеллектом, может привести к созданию роботов-убийц, контролировать которые будет сложно, пишет L’Express. Эта возможность серьёзно беспокоит экспертов и представителей общественных организаций всего мира. Однако ведущие мировые державы продолжают разработку автоматизированного оружия, способного реагировать на угрозу быстрее человека, отмечает издание.

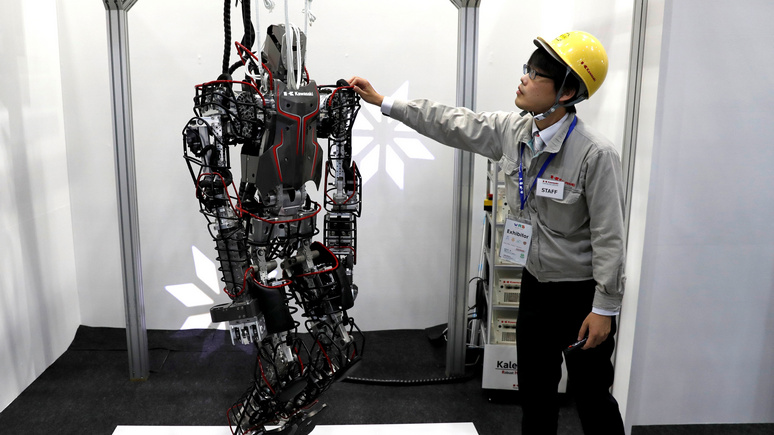

Несмотря на то, что автоматизированные летальные вооружения, управляемые искусственным интеллектом, пока относятся скорее к области научной фантастики, тысячи граждан и экспертов уже требуют их запрета, пишет L’Express. Многочисленные некоммерческие организации уже окрестили эти военные машины, способные открывать огонь по собственной инициативе и призванные, в конечном счёте, заменить солдат на поле боя, «роботами-убийцами», своего рода «терминаторами».

Хотя этот образ и выглядит «карикатурным», причины для беспокойства есть, отмечает журнал. Многие страны, в частности, Китай и США инвестируют серьёзные средства в разработку «военных роботов» и искусственного интеллекта, что в будущем может привести к созданию вооружений, наделённых невиданным ранее уровнем самостоятельности в вопросе принятия решений.

По словам сотрудника Стокгольмского института исследований проблем мира Венсана Буланена, функции перемещения и обнаружения целей на машинах военного назначения уже сегодня становятся все более автоматизированными. Так, автоматическая турель Super aEgis II способна опознавать форму человеческого тела на расстоянии 2-3 километров, как днём, так и ночью. Более того, в данный момент её создатель занят разработкой программного обеспечения, которое позволит ей научиться различать своих и чужих по силуэтам.

Не менее впечатляюще выглядят и тестируемые по обе стороны океана роботизированные мини-танки, оборудованные ракетами, способные перевозить тяжёлые грузы и в автоматическом режиме преследовать наземные войска. Кроме того, существенное развитие произошло из в области разработки дронов, способных сегодня в автономном режиме искать конкретные цели для взрыва.

Тем не менее, в настоящее время «во всех системах вооружений, используемых на поле боя, сохраняется участие человека», — уточняет Буланен. Несмотря на то, что в основе официальной военной доктрины всё ещё лежит понятие подчинения машины человеку, «за кулисами» многие представители индустрии поддерживают идею о том, чтобы однажды отказаться от «оператора в кресле», поскольку это излишне замедляет процесс принятия решений.

В условиях современной войны даже задержка в принятии решения длительностью 5-10 секунд может оказаться фатальной, поэтому доверять управление исключительно человеку, каким бы ни был его уровень подготовки, было бы «заблуждением», полагают некоторые. Именно поэтому американская система противоракетной обороны «Иджис», к примеру, оснащена кнопкой перехода в режим чрезвычайной ситуации, после нажатия на которую урправление будет доверено технике.

«В будущем роботы будут способны анализировать большие объёмы данных, они не дрогнут в момент удара, а траектории движения их снарядов смогут быть оптимизированы», — подчёркивает эксперт Центра изучения проблем безопасности Французского института международных отношений Жан-Кристоф Ноэль.

Вдохновлённые результатами тестов, свидетельствующих о превосходстве искусственного интеллекта перед человеческим в военных операциях, мировые державы инвестируют в развитие этой отрасли миллиарды долларов. Однако «перейти от симуляторов к битвам на местности» будет непросто, поскольку использование военных роботов порождает множество этических вопросов. Главные из них: «осмелимся ли мы дать машине право на убийство человека? Сможет ли она избежать ошибки?»

Реальные возможности искусственного интеллекта ограничены, предупреждают эксперты. Затруднения, с которыми он может столкнуться, хорошо видны на примере ситуации, произошедшей в Китае. Там система распознавания лиц приняла фотографию на автобусе за живого человека, переходящего дорогу на красный свет. «К счастью, она (система. — ИноТВ) не была вооружена», — иронизирует автор статьи. По мнению эксперта по робототехнике из Национального центра научных исследований Жана-Поля Ломона, «такие системы ненадёжны», и «применять их было бы преступлением».

Подобные платформы могут быть крайне сложны и часто основываются на множестве запутанных алгоритмов, что затрудняет «глобальное понимание» принципа их работы, предупреждают эксперты. Уже сегодня машины начинают учиться самостоятельно, завтра они смогут принимать решения об изменении способа обработки данных, не ставя в известность человека. В этом случае оператор окажется неспособен понять механизм управления устройством. «Искусственный интеллект-убийца, который невозможно понять», может стать реальностью.

Несмотря на «сигналы тревоги» со стороны Илона Маска и Стивена Хокинга, многочисленные петиции и обсуждения проблемы в ООН, нет никаких гарантий, что все они смогут помешать применению автономных летальных вооружений, замечает издание.

При этом, как отмечают специалисты, существует множество «мирных» задач, к решению которых неплохо было бы привлечь искусственный интеллект. Среди них наблюдение за состоянием транспортных средств и заблаговременное обнаружение возможных поломок, документооборот на основе поиска по ключевым словам, а также исследование черт лица солдат с целью выявления посттравматического синдрома.

Материалы ИноТВ содержат оценки исключительно зарубежных СМИ и не отражают позицию RT

Оригинал новости ИноТВ:

Оценил 1 человек

1 кармы