Сэм Альтман возглавляющий OpenAI заявил, что объединение LLM и LRM может принести новые научные знания. Обучение все более крупных языковых моделей (LLM) с использованием все большего количества данных заходит в тупик. По словам генерального директора OpenAI Сэма Альтмана, объединение «гораздо больших» предварительно обученных моделей с возможностями рассуждения (LRM) может стать ключом к преодолению ограничений масштабирования предварительного машинного обучения.

Предварительно обученные языковые модели больше не масштабируются так эффективно, как раньше, и эта точка зрения, похоже, получила широкое признание в индустрии ИИ. Теперь Альтман называет предварительное обучение «старым миром». Главный вопрос по его мнению сейчас заключается в том, возможно ли объединить широкие возможности LLM со специализированной точностью LRM.

По словам Альтмана, модели рассуждений обеспечивают невероятный новый прирост эффективности вычислений, а OpenAI может достичь производительности во многих тестах, которую в «старом мире» мы бы предсказывали только в GPT 6» с «моделями, которые намного меньше». Проблема, отметил Альтман, заключается в том, что «когда мы делаем это по-новому, не все становится лучше. Мы можем добиться улучшения в определенных измерениях».

Уже случившийся прогресс в программировании в качестве примера быстрого прогресса посредством обучения с подкреплением: в OpenAI первая модель рассуждений o1 была оценена как лучший миллионный конкурентоспособный программист в мире. К декабрю их модель o3 стала 175-м лучшим конкурентоспособным программистом в мире. Внутреннее тестирование теперь показывает приблизительно 50-е место, и Альтман считает, что «может быть, мы достигнем первого места к концу этого года».

Всем уже давно ясно что похвальба Альтмана это неловкая попытка прикрыть явную ограниченность их модели, которая может решать только конкурсные задачи, но не может решать задачи реальные. И тут уже не спасает масштабирование инфраструктуры, имеющиеся машинные ресурсы для обучения моделей попадают в воронку бутылочного горлышка из небольшого числа уже изобретенных подходов. И все эти подходы другие исследователи решений щепетильно перебрали и на горизонте ничего нового не просматривается.

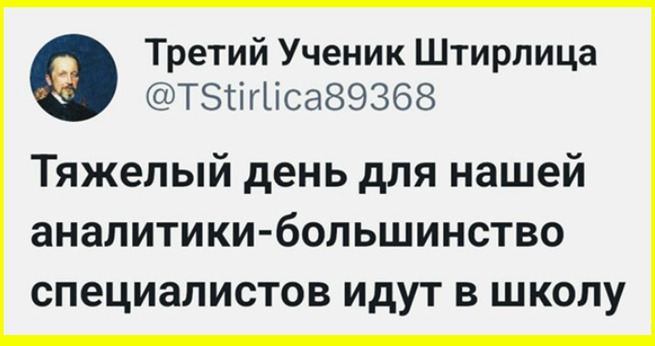

И все эти тирады Альтмана адресованы не тем специалистам программистам, которые всё уже поняли и просто осваивают ИИ в качестве сложного инструмента, не делая громких обещаний. А для людей которые ранее поверили в магию OpenAI, могущество гения самого Альтмана, для тех инвесторов кто не силен в машинном обучении, Сэм рассказывает сказку: двигаем слои нейросетей, соединяем разные нейросетки, ждите и в них циферки станут получше, а может и не станут, мы точно не знаем, но мы стараемся, пока просто верьте, как верите Маску в переселение миллиона людей на Марс. Поэтому OpenAI и другие компании ищут новый путь к более интеллектуальному ИИ, поскольку существующие методы сталкиваются с ограничениями.

Ведущие компании в сфере ИИ меняют курс. Вместо того чтобы разрабатывать всё более крупные языковые модели, они сосредотачиваются на вычислениях во время тестирования, которые требуют больше вычислительной мощности во время выполнения модели, а не при первоначальном обучении. Но когда все эти исследования еще были в начальной стадии, известный всем инвестор Баффет уже интриговал против ИИ в американском финтехе, о чем на Конте уже сообщалось. Очевидно золотой телец обегает стороной ИТ-идеи Сэма Альтмана.

Оценили 12 человек

27 кармы