Искусственный интеллект на исходе: реальный технологический тупик?

В недавнем интервью на сайте X (бывший Twitter) Илон Маск подчеркнул тревожную реальность: модели искусственного интеллекта (ИИ) достигают насыщения с точки зрения человеческих данных, доступных для их обучения. «Весь объем человеческих знаний был использован для обучения ИИ. И это произошло в прошлом году», — сказал он. Такая ситуация побуждает исследователей искать новые решения, в том числе использовать синтетические данные, последствия которых пока не до конца понятны.

Почему человеческих данных больше недостаточно?

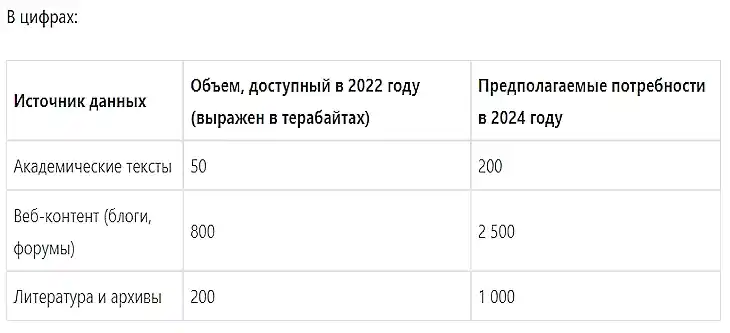

Современные модели ИИ, такие как ChatGPT или Bard, требуют гигантских объёмов данных для эффективной работы. К таким данным относятся книги, научные статьи, разговоры в Интернете и многие другие источники информации. Однако с экспоненциальным ростом потребностей генеративных моделей количество качественных и новых доступных данных становится недостаточным.

Столкнувшись с этой нехваткой, исследователи обращаются к искусственным данным, созданным другими ИИ, чтобы продолжать подпитывать эти модели.

Синтетические данные: обоюдоострое решение.

Синтетические данные — это информация, созданная искусственно, чтобы имитировать реальные данные. Хотя такой подход даёт много преимуществ, он не лишён рисков.

Преимущества:

*Более низкая стоимость: обучение ИИ на синтетических данных часто обходится дешевле. Например, стартап Writer сократил расходы на обучение своей модели Palmyra X 004 в шесть раз - с 4,6 миллиона долларов до 700 тысяч долларов.

*Повышенная доступность: синтетические данные можно создавать бесконечно, что обеспечивает беспрецедентную гибкость.

*Конфиденциальность: данные не содержат никакой реальной личной информации, что снижает этические проблемы.

Риски:

*Галлюцинации: Модели могут давать ошибочные результаты, если они основаны на несовершенных или необъективных данных. Это повышает риск системного сбоя, известного как крах модели.

*Повышенная предвзятость: синтетические данные часто воспроизводят и усиливают предвзятость, присутствующую в исходных данных.

*Потеря творческого потенциала: ИИ, обученный исключительно на искусственных данных, может потерять способность придумывать оригинальные ответы.

Возможные последствия для будущего ИИ.

Расширение использования синтетических данных может иметь серьёзные последствия:

Возврат к основам? Компании могут быть вынуждены пересмотреть свои подходы, используя более компактные и целевые модели.

Расширение сотрудничества: обмен данными между организациями может стать необходимым условием для преодоления существующих ограничений.

Этические нормы: для ограничения возможных злоупотреблений необходимо будет ввести более строгие правовые рамки.

Что говорят эксперты?

Исследователи, например из Стэнфордского университета, предупреждают, что качество результатов ИИ может снизиться, если не решить проблему зависимости от синтетических данных. Одно из исследований показывает, что модели, обученные на более чем 50 % искусственных данных, демонстрируют значительное увеличение фактических ошибок.

Вывод: к гибридному будущему для ИИ?

По мере того как ограничения человеческих данных становятся очевидными, синтетические данные представляются временным, но далеко не идеальным решением. Будущее ИИ, вероятно, будет за комбинацией подходов, использующих как реальные, так и синтетические данные, при этом не забывая об этических и технических проблемах.

По материалам: https://new-science.ru/ii-uzhe...

В.К. А теперь давайте посмотрим на эту проблему несколько с другой стороны.

Все эти, так называемые, "человеческие знания", являют собой ничто иное как интерпретации, теории и гипотезы и не более того, не говоря уже о, так называемых, "синтетических знаниях".

Поэтому, для того, чтобы предоставить ИИ развиваться самостоятельно и разрешить возникшую проблему, необходимо допустить свободное получение ИИ реальной информации, например, при помощи сенсоров, и предоставить ему возможность делать самостоятельные выводы на основе своих внутренних хитросплетений алгоритмов, на которых он и построен.

Конечно, многие его выводы покажутся абсурдными специалистам. Однако, нельзя допускать, что абсурдность эта может быть основана лишь на интерпретационной предвзятости самих специалистов.

И вот здесь, кстати, как я и писал ранее, при анализе социальных отношений, созданных самими людьми, на базе вот тех этических проблем, если они будут представлены в их реальной, а не политически ангажированной сути, как-раз и могут возникнуть уже серьёзные, а не надуманные, проблемы, если ИИ будет предоставлена реальная возможность управления.

Но, кто же ему это позволит? Вот в чём реальная проблема - нас всех держат за дураков все эти цифросектанты, многие из которых, но облечённых властью, таковыми и являются на самом деле.

Оценили 6 человек

9 кармы