Уязвимости языковых моделей усиливают риски и создают новые проблемы.

Эксперты Microsoft исследовали безопасность более 100 продуктов компании с использованием генеративного ИИ и пришли к выводу: модели усиливают уже существующие риски и создают новые. Исследование описано в статье Lessons from red-teaming 100 generative AI products, подготовленной 26 авторами, включая технического директора Azure Марка Руссиновича.

Авторы подчёркивают, что полностью обезопасить ИИ-системы невозможно, однако дальнейшие меры, такие как принципы защиты по умолчанию и многоуровневая защита , могут усложнить атаки. Один из главных выводов — безопасность моделей требует постоянной работы.

В статье описаны восемь ключевых уроков. Первый из них — важно понимать, как модель функционирует и где применяется. Это особенно важно, поскольку разные модели имеют разные риски в зависимости от области использования. Например, атака на ИИ, помогающий писать тексты, менее опасна, чем атака на модель, работающую с медицинскими данными.

Второй урок: для успешной атаки не всегда нужны сложные вычисления. Более простые методы, такие как манипуляции с интерфейсом или вводящая в заблуждение визуальная информация, часто более эффективны.

Третий урок отмечает различие между бенчмаркингом и "красной командой". Первое измеряет известные риски, второе выявляет новые угрозы. Это важно для создания эффективной стратегии защиты.

Четвёртый урок связан с автоматизацией. Microsoft разработала открытый инструмент PyRIT (Python Risk Identification Toolkit), который помогает выявлять риски быстрее. Однако его же можно использовать и для атак на ИИ.

Пятый урок напоминает, что автоматизация не заменяет человеческий фактор. Компетенции экспертов, культурная осведомлённость и эмоциональный интеллект играют решающую роль. Также необходимо учитывать возможное воздействие на психологическое состояние участников "красных команд", которые могут сталкиваться с большим количеством тревожного контента.

Шестой урок подчёркивает сложность измерения вреда, причиняемого ИИ. В отличие от программных уязвимостей, такие риски часто амбивалентны и субъективны. Примером может служить гендерный стереотип в изображениях, создаваемых по определённым текстовым запросам.

Седьмой урок утверждает, что LLM (языковые модели) усиливают существующие риски и создают новые. Авторы отмечают, что языковые модели, получив небезопасные входные данные, могут генерировать произвольный контент, включая утечки конфиденциальной информации.

И, наконец, последний урок напоминает, что работа над защитой ИИ никогда не закончится.

Эти выводы особенно важны на фоне активного внедрения ИИ в продукты Microsoft. Новые риски потребуют привлечения большего числа специалистов для их устранения.

По материалам: https://www.securitylab.ru/new...

В.К. А прогрессирующий идиотизм можно остановить? Нет? Ну тогда, чего удивляться, то нельзя остановить ИИ?

ChatGPT вместо мозгов: школьники массово переходят на ChatGPT.

Данные показывают, как ИИ меняет учебный процесс.

Эпоха технологий продолжает менять учебный процесс в школах, сталкивая учителей с новыми вызовами. Если в прошлом ученикам запрещали использовать калькуляторы и энциклопедии на CD-ROM, сегодня они активно осваивают инструменты искусственного интеллекта, такие как ChatGPT. Согласно новому исследованию Pew Research Center, доля подростков, использующих ChatGPT для выполнения школьных заданий, за год увеличилась с 13% до 26%.

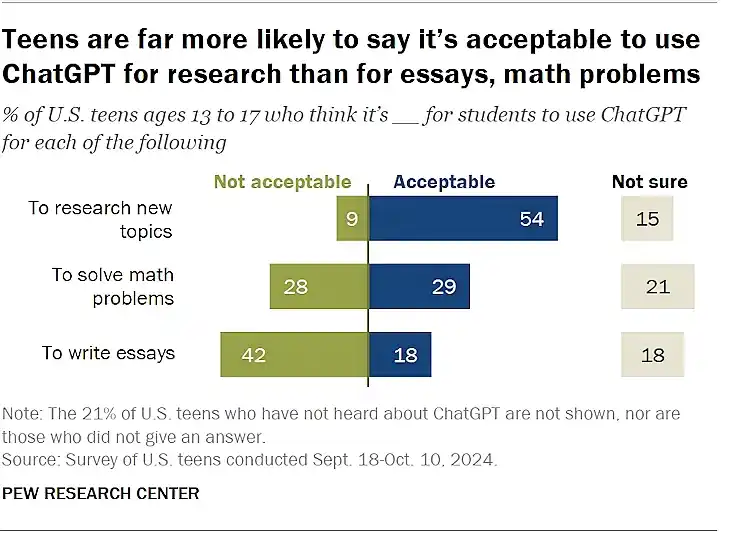

Молодёжь стремится облегчить школьную рутину, однако данные Pew показывают, что подход к использованию ИИ довольно избирателен. Например, 54% подростков считают приемлемым использование ChatGPT для изучения новых тем. Но этот показатель резко падает, когда речь идёт о решении математических задач (29%) или написании эссе (18%).

ChatGPT — далеко не единственный инструмент, доступный ученикам. Исследование Digital Education Council, опубликованное в августе, утверждает, что глобальный уровень использования ИИ среди студентов достигает 86%. Помимо ChatGPT, в обиходе подростков появляются такие платформы, как Gemini, Claude и Microsoft Copilot.

Некоторые школы уже экспериментируют с интеграцией ИИ в обучение . Например, Университет штата Аризона (ASU) сотрудничает с OpenAI, а лондонский колледж David Game запустил курс, частично преподаваемый ИИ в рамках программы Sabrewing.

Однако широкое использование искусственного интеллекта вызывает опасения. Учёные опасаются, что студенты могут стать чрезмерно зависимыми от технологий, что помешает развитию критического мышления. С другой стороны, ИИ может стать мощным инструментом для персонализации учебного процесса, если его использовать разумно. Ограничить применение ИИ в школах полностью практически невозможно, но выработка сбалансированного подхода может стать эффективным решением.

По материалам: https://www.securitylab.ru/new...

ИИ не друг: чем опасны иллюзии о мыслящих машинах?

Неверные термины вводят в заблуждение и мешают понимать реальные возможности технологий.

Современная тенденция наделять искусственный интеллект человеческими чертами представляет собой растущую опасность, искажающую наше понимание возможностей этих систем. Эта ошибка — антропоморфизация ИИ — уже влияет на ключевые решения в бизнесе, политике и законодательстве. Лидеры бизнеса сравнивают обучение ИИ с человеческим, оправдывая этим методы работы, а законодатели опираются на ошибочные аналогии, принимая важные решения.

Мы часто используем выражения, такие как «ИИ учится», «думает», «понимает» или «создаёт». Эти термины кажутся естественными, но в корне неверны. ИИ не «обучается», как человек, а использует математические алгоритмы для анализа данных. Исследования показали, что подобный язык вводит в заблуждение, заставляя думать, будто ИИ действует независимо от данных, на которых он обучен. Это искажённое представление влияет на восприятие технологий и может привести к неверным выводам, особенно в вопросах авторского права.

ИИ не обладает способностью к рассуждению, характерной для человека. Его основная задача — распознавание шаблонов и предсказание последовательностей, основанных на больших объёмах данных. Эта принципиальная разница ярко проявляется в задачах, где требуется логическое мышление. Например, если модель обучена утверждению «A равно B», она может не понять, что «B равно A».

Ошибочное представление об ИИ особенно опасно в области авторского права. Сравнения обучения ИИ с человеческим могут привести к недооценке значимости соблюдения прав интеллектуальной собственности. В отличие от человека, который запоминает и интерпретирует информацию, ИИ делает копии данных и сохраняет их в своих системах. Это порождает вопросы о законности использования обучающих материалов.

Антропоморфизация также создаёт риски для бизнеса. Руководители, считая ИИ «интеллектуальным» или «творческим», склонны переоценивать его возможности. Это может привести к недостаточному контролю над генерацией контента, нарушению авторских прав и ошибкам в трансграничном соблюдении законодательства. Каждая страна имеет свои правила в отношении авторского права, и то, что разрешено в одном месте, может считаться нарушением в другом.

Ещё один важный аспект — эмоциональная зависимость от ИИ. Люди могут воспринимать чат-ботов как друзей или коллег, что приводит к неуместному доверию и раскрытию конфиденциальной информации. Это затрудняет принятие рациональных решений и усиливает психологические риски.

Для преодоления этой проблемы важно изменить язык, который мы используем для описания ИИ, и отказаться от антропоморфных терминов. ИИ следует рассматривать как инструмент анализа данных, а не как мыслящего субъекта. Чёткое понимание его возможностей и ограничений поможет избежать юридических, этических и практических ошибок.

Подробнее: https://www.securitylab.ru/new...

Оценили 4 человека

8 кармы