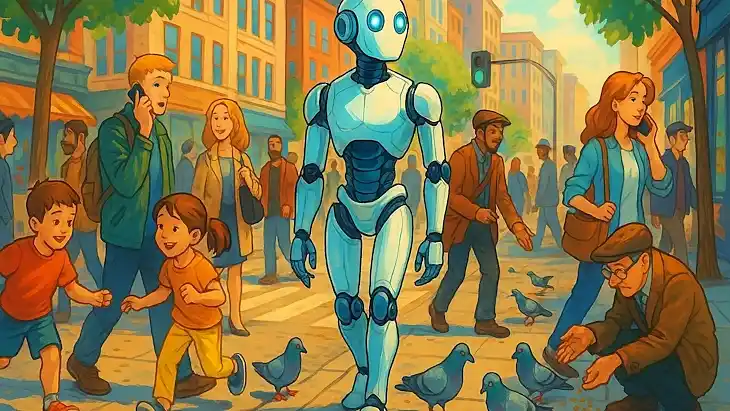

ИИ теперь не просто гуглит ответ — он думает, ошибается и спорит.

Искусственный интеллект достиг впечатляющих результатов в тестах вроде Тьюринга, но учёные предупреждают: эти успехи могут быть обманчивыми. Модели научились “играть” с бенчмарками, но не стали от этого умнее в человеческом смысле. Исследователи из DeepMind, подразделения Google, считают, что дело не в самих тестах, а в том, как мы обучаем ИИ. Современные модели слишком зависят от фиксированных наборов данных и коротких запросов, и никогда не смогут выйти за рамки заложенных в них ограничений — если только им не дать возможность учиться на опыте.

В новой работе, опубликованной как часть будущей книги издательства MIT Press, ведущие эксперты в области искусственного интеллекта Дэвид Сильвер и Ричард Саттон предлагают новую парадигму — “эпоху опыта”. Они уверены: если позволить ИИ не просто отвечать на вопросы, а накапливать собственный опыт взаимодействия с миром, он сможет формировать цели, учиться на ошибках и адаптироваться. Именно этого, по их мнению, не хватает сегодняшним языковым моделям вроде ChatGPT.

Сильвер и Саттон — не просто теоретики. Первый стоял у истоков создания AlphaZero — программы, победившей чемпионов мира в шахматах и игре Го. Второй — один из разработчиков метода обучения с подкреплением, за который получил премию Тьюринга. Их предложение основывается на этом подходе и развивает его через концепцию "потоков" — непрерывного опыта, который ИИ должен получать, действуя в мире.

Проблема, как они описывают, в том, что современные ИИ-модели слишком зависят от человеческих подсказок. Мы даём им инструкции, на которые они отвечают, не выходя за рамки заданного. Такие модели не могут открыть что-то новое или неожиданное — их поведение ограничено ожиданиями человека. А ведь ключ к прогрессу — способность ИИ к самооткрытию, к постановке собственных целей и поиску путей их достижения.

Модели вроде AlphaZero могли играть в шахматы и другие строго определённые игры, но они были бессильны в реальных, неопределённых ситуациях. Генеративный ИИ, наоборот, умеет работать с непредсказуемыми человеческими запросами. Но он отказался от обучения с подкреплением, потеряв при этом самую важную часть — способность учиться на опыте, а не только на данных. В результате — ни памяти, ни понимания контекста между сессиями, ни возможности адаптироваться к долгосрочным задачам.

“Потоки опыта”, по мнению DeepMind, могут это изменить. Вместо коротких взаимодействий с пользователем ИИ получит непрерывную ленту взаимодействия с окружающим миром — как человек, который учится на протяжении всей жизни. Такие ИИ смогут не просто отвечать, но и наблюдать, запоминать, адаптироваться и ставить себе цели, руководствуясь не только командами, но и окружающими сигналами.

Исследователи подчёркивают, что всё необходимое для начала уже есть. Примеры — браузерные ИИ-агенты, способные взаимодействовать с вебом через интерфейс, как человек. Это уже шаг от простого текстового общения к более автономному действию. Следующий шаг — дать ИИ возможность получать "награды" из окружающего мира, как в обучении с подкреплением. Это могут быть метрики эффективности, стоимости, ошибок, здоровья, продуктивности, дохода, лайков, климата и сотни других сигналов, которые уже существуют вокруг нас.

Стартовать ИИ может с симуляций — “моделей мира”, в которых он будет тестировать гипотезы, получать обратную связь и корректировать поведение. По мере взаимодействия с реальностью эта модель будет становиться всё точнее. Пользователь по-прежнему может задавать цели — например, “улучшить мою физическую форму” или “помоги выучить испанский” — а система будет находить, как их достичь, используя всю полноту доступного опыта.

Такие агенты смогут сопровождать человека не в течение сессии, а годами: отслеживать питание, здоровье, прогресс в обучении, выстраивать сложные долгосрочные стратегии. Или, как пишут авторы, заниматься настоящими научными задачами — моделированием климата, разработкой новых материалов, оптимизацией экономики.

По мнению Сильвера и Саттона, такие “опытные агенты” могут превзойти нынешние модели, даже те, что заявлены как “разумные” или “рассуждающие” — вроде Gemini, DeepSeek R1 или OpenAI o1. Эти модели, как утверждают исследователи, лишь воспроизводят человеческие мысли — и повторяют те же ошибки и предрассудки, что и люди. Настоящий прогресс возможен, если ИИ сможет опираться не на прошлое человечества, а на собственный опыт.

Разумеется, у подхода есть риски. Автономные агенты, способные действовать в мире без постоянного контроля человека, могут стать проблемой — в том числе и в экономике. Но в то же время, подчёркивают авторы, такие системы смогут адаптироваться: распознавать недовольство человека и менять поведение, чтобы не причинять вреда. Главное — задать верные цели.

Идея “эпохи опыта” — это не просто новая модель, это смена всей парадигмы. По мнению DeepMind, данные, полученные ИИ из собственного опыта, многократно превзойдут по объёму и полезности всё, что человечество когда-либо записало в Википедии или Reddit. Это не просто следующий шаг — это путь к настоящему сверхинтеллекту.

По материалам: https://www.securitylab.ru/new...

В.К. Вообще, о приобретении опыта я писал ранее, если вы помните. Только весь вопрос в том, откуда этот опыт будет приобретаться? От различных придурков, выкладывающих свои якобы знания в интернет или в небо, как пишут авторы? А критерием истинности будут выступать подкрепления? Всё это похоже не на приобретение опыта, а на дрессировку. И о какой, собственно, первоначальной симуляции вообще идёт речь? А приобретением опыта будет перебор и комбинирование возможных вариантов первоначальной симуляции?

Для приобретения опыта необходима чистая непредвзятая информация, полученная в разнообразных отношениях и в разнообразном же окружении. И, каким образом и откуда будет получаться такая информация?

Вообще, честно говоря, задача, на сегодняшний день и на ближайшую перспективу, абсолютно не решаемая. Да, какие-то результаты будут получены и, по людским оценкам, возможно, даже положительные. Но не будет никакой гарантии в том, что не будет получена очередная химера знания, а не собственно знания.

Людской разум проходил огромный путь в приобретении опыта, но так и не избавился, на сегодняшний день, от иллюзий приобретения опыта пребывания в истине и не потому, что зачастую игнорирует очевидное, а потому, что придумывает истинное. Но у людского разума есть жёсткий критерий истинности - сама истина, поскольку он и является её реализацией. А реализацией чего является ИИ?

Оценили 2 человека

2 кармы