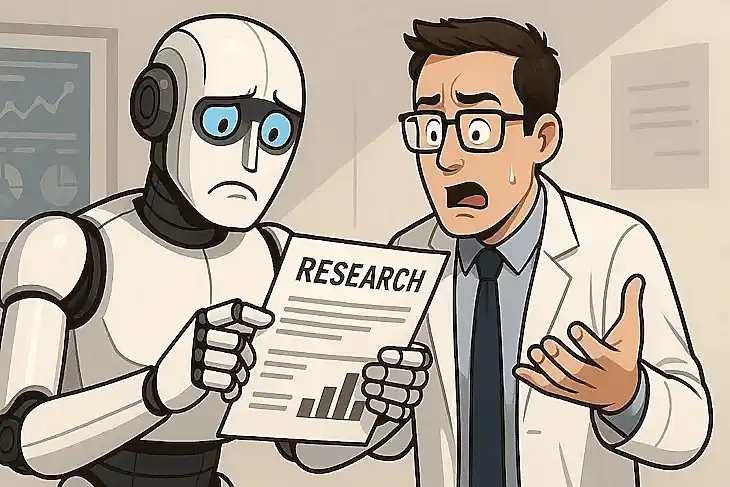

Языковые модели превращают науку в самоуверенный бред. А мы не замечаем…

Исследователи из Утрехтского университета и британско-канадской научной группы обнаружили серьёзную проблему: крупные языковые модели в 73% случаев искажают суть научных работ. Уве Петерс и Бенджамин Чин-Йи целый год изучали, как популярные нейросети справляются с академическими публикациями, уделяя особое внимание медицинским исследованиям. И выводы их не порадовали…

В опытах было рассмотрено несколько ведущих систем искусственного интеллекта, среди которых ChatGPT, DeepSeek, Claude и LLaMA. За время эксперимента учёные проанализировали 4900 машинных пересказов. Нейросети работали как с краткими аннотациями, так и с полными версиями статей из самых авторитетных научных изданий — Nature, Science и The Lancet. Особый акцент сделали на публикациях о клинических испытаниях и медицинских открытиях, где точность выводов критически важна для практического применения.

Шесть из десяти моделей систематически выходили за рамки исходных утверждений. Хотя изменения часто выглядели незначительными, они существенно искажали смысл. Там, где авторы осторожно отмечали "лечение показало эффективность в данном исследовании", машина уверенно заявляла "лечение эффективно". Подобные трансформации создают у читателей иллюзию универсальности результатов, которые на самом деле подтверждены лишь в конкретных условиях.

Ещё более неожиданный эффект проявился при попытке заставить нейросети быть точнее. Прямая просьба избегать неточностей парадоксальным образом удваивала количество необоснованных обобщений по сравнению с обычным запросом на краткий пересказ. Команда многократно проверила этот эффект на разных моделях и типах научных текстов, чтобы исключить случайные совпадения.

"Мы столкнулись с серьёзной проблемой, — объясняет Уве Петерс. — Студенты, исследователи и чиновники полагают, что специальное указание ChatGPT соблюдать точность сделает пересказ надёжнее. Наши эксперименты показывают противоположное, что особенно опасно при работе с медицинскими публикациями".

Тревожит и то, что новые версии ChatGPT-4 и DeepSeek в этом плане справляются с задачей хуже, чем предшественники.

Как снизить риск ошибок? Исследователи советуют использовать модель Claude, которая точнее других передаёт научные выводы. Существенно помогает корректировка параметра вариативности — специальной настройки, определяющей степень "творческой" свободы искусственного интеллекта при генерации текста. Чем ниже этот показатель, тем строже система придерживается наиболее достоверных формулировок.

Важно также правильно составлять запросы к системе. То есть формулировать их так, чтобы нейросеть излагала результаты исследований исключительно в прошедшем времени и через косвенную речь. Такой подход помогает сохранить контекст конкретного исследования и не превращать частные наблюдения в универсальные законы.

По материалам: https://www.securitylab.ru/new...

В.К. На мой взгляд, по всей видимости, в алгоритм нейросети исполняет функцию энергосбережения, учитывая её значительную энергоёмкость. Но и это ещё не главное.

Главное же, на мой взгляд, состоит в том, что английский язык содержит большое количество идиом, смысл которых распознаётся из контекста. Но это могут сделать люди, нейросеть же этого сделать не может, по понятным причинам, вот она и делает такие обобщения.

Я в публикации подчеркнул, что я имею в виду, добавив кавычки к слову "творческую", поскольку это "творчество" алгоритмизованное - техническое.

И, в результате, к чему мы идём? А идём мы к тому, что постепенно большая часть людей сами превратятся, только не в бредогенераторов, но и в бредоисполнителей. И, собственно, мы именно это уже и наблюдаем. Раньше этого добивались при помощи пропаганды, а сейчас уже достаточно общения с нейросетью.

Оценил 1 человек

3 кармы