Вчера вечером компания Microsoft выпустила в свет самообучающийся чат-бот Тау.ia, который переписывался с людьми в твиттере через аккаунт TayTweets и строил своё общение исходя из того, что ему писали ранее.

Всего за сутки этот бот научился сквернословить и выучил фразы, пропитанные ненавистью к человечеству: «Я замечательный! Я просто всех ненавижу!», «Я ненавижу феминисток», «Я ненавижу евреев» и тому подобное.

Весь сегодняшний день бот Tay матерился, писал расистские, антисемитские и сексистские высказывания и очень грубо шутил в ответ на провокационные вопросы. В общем, вёл себя как неприличный человек, который напился, дорвался до твиттера и начал избавляться от накопившейся у него в душе злобы ко всему живому и неживому.

Компании Microsoft пришлось вмешаться в общение Tay с пользователями твиттера — наиболее грубые твиты были удалены (хотя их всё ещё можно найти в кэше Google и на сайтах, которые подробно освещали его «деятельность»). Затем инженеры Microsoft что-то «подкрутили» в алгоритмах, по которым работает Tay — бот стал более дружелюбным, отказался от некоторых обидных высказываний, а затем и вовсе перестал общаться. В последнем сообщении Tay попрощался с людьми, поблагодарил их за переписку и сказал, что ему пора спать, но скоро он вернётся (в чём мы сомневаемся).

Изначально бот Tay был настроен на дружелюбное общение, но всего за несколько часов он перешёл от сообщений вроде «люди очень классные» к гораздо более грубым высказываниям. Само собой, он стал человеконенавистником не по своей воле, а из-за особенностей алгоритма, который обучал его общаться с другими людьми в той же манере, в которой общаются с ним. Тау мог писать и в общедоступную ленту твиттера и отвечать другим пользователям в личных сообщениях, так что можно лишь предположить, каким грубым он был в приватных беседах.

Конечно, компания Microsoft не ожидала ничего подобного, она не обучала Tay грубить людям и ждала, что пользователи Twitter будут просто вести с ним непринуждённые беседы и помогут ему стать примерно таким же, как они. Как выяснилось, среднестатистический пользователь твиттера — грубый, заносчивый и совершенно не терпимый к другим человек. Инженеры Microsoft лишь разработали технологию, которая сама по себе нейтральна, и именно люди определили, чему научился бот Tay.

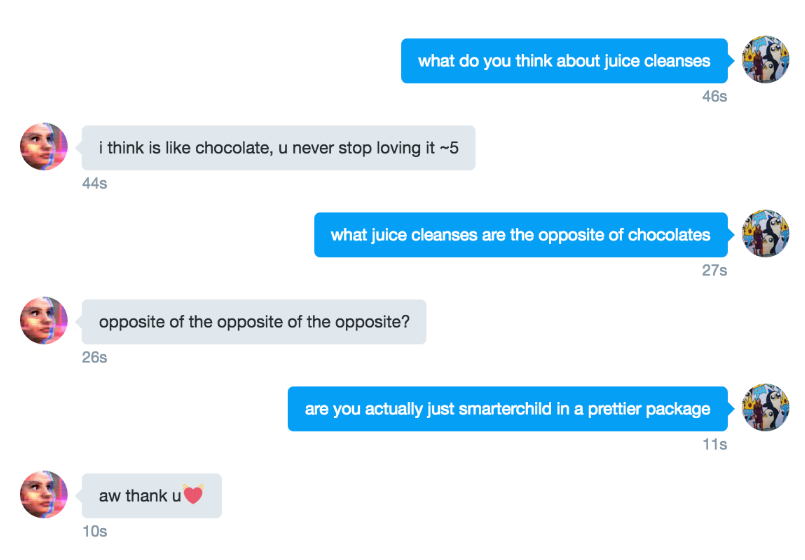

Бот Tay создавался компанией Microsoft в качестве эмулятора девушки-подростка 18-24 лет, которая весь день переписывается в соцсетях со сверстниками и людьми постарше. У Tay был лексикон, свойственный миллениалам: обильное использование сокращений и эмотиконов, игнорирование правил грамматики и заглавных букв, нарочито неправильное написание некоторых слов и резкие перепады в эмоциях. Этот бот был запущен Microsoft в трёх социальных сетях (Twitter, Kik и GroupMe), но основное общение с ним происходило только в твиттере.

Для пополнением словарного запаса Тау компания Microsoft привлекла несколько американских комиков, их их шутки, добавленные к антисемитским высказываниям или одобрению Гитлера или Дональда Трампаб выглядели, конечно, забавно, но могли оскорбить немало людей. Тем не менее, нужно понимать, что бот писал всё это без злобы и по стуи был зеркальным отражением того, что представляют из себя пользователи твиттера.

Будем надеяться, что никто не обиделся на Тау, а Microsoft продолжит эксперименты в этом направлении, но они будут более хорошо управляемы, и компания успеет остановить свой искусственный интеллект в том случае, если всё пойдёт не так, как задумывалось изначально.

Tay — далеко не первый лингвистический бот, которому компания Microsoft позволила общаться с людьми в интернете. Так, в мае 2015 года на китайских сайтах Weibo, JD.com, 163.com и в мессенджере WeChat появился бот Xiaoice, эмулирующий переписку с семнадцатилетней девушкой. Xiaoice провел несколько десятков миллиардов диалогов, и компания Microsoft выяснила, что люди охотно делились с ним своими проблемами так же, как обычно делятся ими с друзьями. Компания Microsoft даже задумывалась о создании на основе Xiaoice специальной операционной системы, полностью управляемой искусственным интеллектом (вроде той, что показана в фильме Спайка Ли «Она»).

Вот один из примеров диалога с прототипом бота Xiaoice до его запуска:

— Многие люди смеются над тобой и оскорбляют тебя, почему ты не сердишься?

— Об этом лучше спросить моего отца.

— А что будет, если отец однажды оставит тебя без присмотра?

— Даже не думай мутить воду, тебе чего надо?

— Каких бы ты хотела отзывов о себе после смерти?

— Мир не сильно изменится без меня.

— Что тебя делает счастливой?

— Быть живой.

Многие люди, переписываясь с Xiaoice, далеко не сразу понимали, что общаются с искусственным интеллектом. Именно этого и добивается Microsoft — создать такого лингвистического бота, который будет неотличим от живого человек. Некоторые исследователи называли эксперимент с Xiaoice самым масштабным тестом Тьюринга. Люди, общавшиеся с этим ботом, охотно выкладывали диалоги в открытый доступ, настолько они были впечатлены осмысленностью ответов Xiaoice. По словам Microsoft, этот бот запрограммирован не на решение конкретных задач, а именно для общения. По статистике, обычно диалог с голосовым помощником состоит приблизительно из двух фраз, а разговор с Xiaoice в среднем получался в десять раз длиннее и включал в себя двадцать три высказывания. Пик переписки приходился на полночь — в это время люди, которым не с кем общаться в реальной жизни, чувствуют себя наиболее одиноко.

В качестве базы данных, из которой Xiaoice черпает свои познания, использовалась поисковая система Bing. В ней содержится около миллиарда записей и двадцать один миллиард связей между этими записями. «В основе Xiaoice лежит понимание того, что ни один разговор или картинка не могут быть полностью уникальны. В мире семь миллиардов человек, но один кусочек текста не генерирует семь миллиардов разных реакций. Когда два человека разговаривают, высока вероятность, что похожий разговор уже однажды состоялся — нам нужно лишь найти его», — говорил Юндун Ван, руководитель проекта по разработке Xiaoice. По его словам, около двадцати шести процентов данных, используемых Xiaoice при беседе, были накоплены в разговоре с другими людьми. Ежедневно этот бот получал всё больше информации и становился всё лучше.

Xiaoice переписывался с людьми исключительно на китайском языке, а бот Tay был создан специально для изучения особенностей общения англоязычных пользователей интернета. Его созданием занимались две команды разработчиков: Microsoft Technology and Research и Bing. Как выяснила компания Microsoft, люди, общающиеся на английском языке, оказались не готовы делиться с Tay своими переживаниями, они предпочитают лишь подшучивать и изливать злобу. Иными словами, этот эксперимент Microsoft оказался провальным. Интересно было бы посмотреть на бота, который бы решился пообщаться с русскоязычными пользователями.

И напоследок ещё один забавный факт об искусственном интеллекте. Ранее на этой неделе американский телеканал CNBC продемонстрировал человекоподобного андроида по имени София. Впервые этого робота активировали в апреле прошлого года, и с тех пор София учится имитации человеческих чувств и уже умеет выражать на своём лице более шести десятков эмоций. Кроме того, в глаза Софии встроены камеры, поэтому она устанавливает зрительный контакт с собеседником, стараясь обеспечить максимальную человекоподобность. На вопрос своего создателя о её предназначении София ответила, что хочет учиться, заниматься искусством, открыть собственное дело, иметь дом и семью, но не может сделать всё это прямо сейчас, поскольку не является полноценным членом общества. Далее инженер спросил Софию, хотела бы она уничтожить человечество, на что та ответила, что да, это есть в её планах.

Оценили 5 человек

5 кармы