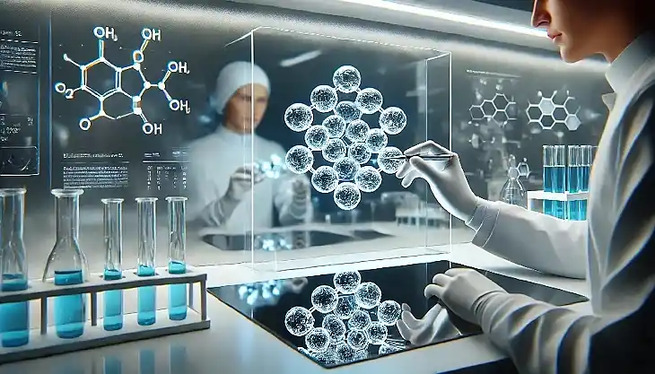

В эксперименте нейросеть ChatGPT успешно справилась с вопросами о вакцине против Covid-19. Хотя ответы генеративного искусственного интеллекта развенчивали мифы и опровергали выдумки о прививках, у исследователей остаются опасения.

© 2015 Christian Emmer.

В 2019 году ВОЗ назвала недоверие к вакцинам одной из десяти главных проблем здравоохранения. В организации отметили, что нежелание прививаться «может обратить вспять тот прогресс, который был достигнут в борьбе с болезнями, предупреждаемыми с помощью вакцин». Во время пандемии Covid-19 дезинформация в социальных сетях ухудшила отношение людей к вакцинации и другим мерам борьбы с коронавирусом.

Группа учёных из Испании решила проверить, что получится, если для борьбы с лженаучными идеями о прививках использовать популярный чат-бот ChatGPT. Для этого исследователи задали нейросети 50 самых частых вопросов о вакцине против Covid-19, которые поступали в ВОЗ. Некоторые из них касались распространённых заблуждений и мифов. Например, может ли мРНК вакцины встраиваться в геном человека или вызывать «продолжительный» Covid-19. Кроме того, вопросы затрагивали ложные и истинные противопоказания, а также рекомендации по прививкам.

Учёные оценили достоверность и точность ответов, проанализировали их соответствие научным данным, рекомендациям ВОЗ и других международных организаций. Большинство ответов ChatGPT набрали девять баллов из десяти возможных, 85,5% из них были точными, а 14,5% — «точными, но с пробелами в информации», которые нуждались в дополнении.

Исследователи отметили, что поскольку сообщения чат-бота отвечают научным данным и развенчивают циркулирующие в соцсетях мифы, ChatGPT может способствовать росту числа вакцинированных.

«Результаты говорят, что, несмотря на неполноту ответов по умолчанию в текущей версии ChatGPT, в целом они удовлетворительны. Хотя ChatGPT не может заменить эксперта или сами научные данные, эта форма искусственного интеллекта (многие учёные не согласны с тем, что ChatGPT — ИИ, классифицируя его как „китайскую комнату“. — Прим. ред.) способна направлять пользователей к информации, которая хорошо согласуется с научными данными», — говорится в работе, опубликованной в журнале Human Vaccines and Immunotherapeutics.

Однако учёные не забыли и о недостатках ChatGPT. Ведущий автор работы Антонио Салас (Antonio Salas) указал, что чат-бот отвечает по-разному, если повторять вопрос с задержкой в несколько секунд.

Профессор Салас предостерёг, что в нынешней версии ИИ-систему можно обучить и обратному, то есть давать ответы, противоречащие научным данным. В таком случае чат-бот способен продвигать ложные взгляды вроде гипотез о плоской Земле или отрицании эволюции. Впрочем, исследователи обнадёжили: по умолчанию нейросеть к такому поведению не склонна.

По материалам: https://naked-science.ru/artic...

P.S. В.К. Не поверите, но меня, честно говоря, просто смешат такого рода "информационные" сообщения.

Ну действительно: по каким критериям определялась научность или не научность, используемых нейросетью утверждений, на основе которых, скажем так, нейросеть делала выводы? На основе их авторитетности и статистической выборки, а не на экспериментальной проверке этих утверждений. Ведь нейросети больше не на чем обучаться. Я ранее уже писал об этом. А поскольку и в закрытом обучении особенно, и в свободном обучении превалируют тенденциозные утверждения, созданные по разным причинам, о научной чести и честности говорить здесь не приходится, их минимальное количество, то нет ничего удивительного и в таких, скажем так, выводах нейросети.

До дебилов никак не дойдёт, что при таком использовании нейросетей, если, конечно, это не делается специальным образом по понятным причинам, мы сами себя и всю свою цивилизацию загоняем в гроб. И участь сия никого не минет, кто бы и какие бы планы себе ни строил и сколько бы веков себе ни намерял.

Оценили 3 человека

3 кармы