Большие языковые модели (LLM), например, ChatGPT и DeepSeek, сегодня стали неотъемлемой частью информационного пространства. Они помогают генерировать тексты, отвечают на вопросы и выполняют множество других задач. Однако исследователи из Массачусетского технологического института (США) обнаружили, что все эти модели, несмотря на свое кажущееся совершенство, часто страдают от “предвзятости позиции”.

Это нередко сказывается на качестве их работы.

Что это такое

Предвзятость позиции — это феномен, при котором языковые модели переоценивают информацию, содержащуюся в начале и в конце текста, игнорируя или недооценивая данные в середине. То есть, по сути, проявляя к ним невнимательность. Это явление может создавать трудности для авторов, которые пытаются выделить ключевые фразы или идеи в длинных документах. Например, в исследовании, представленном на Международной конференции по машинному обучению, было показано, что модель имеет 85% вероятность найти нужную информацию в начале или в конце текста, но только 60% — в середине.

В чем причина

Команда под руководством Синьи Ву разработала теоретическую модель, объясняющую, почему LLM часто фокусируются на начале и конце текста. Основная причина заключается в том, как эти модели обрабатывают информацию. Они читают текст по частям и “приглядываются” к наиболее значимым словам, чтобы правильно интерпретировать смысл. Однако, из-за определенных технических ограничений (в частности, способности учитывать только предыдущие слова или фиксированный порядок слов) возникает смещение.

Модели, как правило, обучаются на больших объемах текста, где начало и конец часто содержат важные вводные и заключительные моменты. Это создает ложное впечатление о том, что информация в этих частях текста более значима, чем в середине. В результате, когда модель анализирует новый текст, она может неправильно оценить важность информации, содержащейся в центральной части.

U-образный эффект

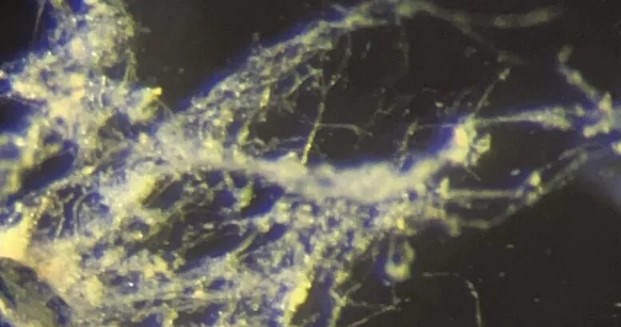

Исследования также показали, что точность распознавания информации у языковых моделей выше на краях текста и заметно хуже в центре, что называется U-образным эффектом. Этот эффект особенно выражен в больших моделях, таких как GPT-4, которые обладают до 96 слоями анализа. Чем больше слоев, тем сложнее становится процесс интерпретации, что может усугублять предвзятость позиции.

Оценили 9 человек

13 кармы